Zusammenfassung

- Die miteinander verbundenen Nervenzellen bilden ein neuronales Netz.

- Durch Simulation dieser Netze mit unterschiedlichen Strukturen lässt sich die Funktionsweise des Gehirns simulieren und einfache Lernvorgänge und Reaktionen verstehen.

- Dabei organisieren sich neuronale Netze selbst, so dass sie auch bei teilweisen Systemausfall, sich wieder regenerieren können (Neuroplastizität)

Serielle und parallele Datenverarbeitung

Wie organisieren sich ca. 200 Milliarden Neuronen in unserem Gehirn? - In der neueren Gehirnforschung ist man dazu übergegangen, das Modell des Netzwerkes für die Simulation von Gehirnfunktionen zu verwenden.

Damit wird deutlich, dass die Datenverarbeitung in unserem Gehirn nicht linear durch die Abarbeitung eines Programmes erfolgt, sondern, dass eine Vielzahl von Neuronen gleichzeitig an Datenverarbeitungsprozessen beteiligt sind.

Bei einem herkömmlichen Datenverarbeitungsprozess werden eine Reihe von Regeln und Prüfverfahren der Reihe nach abgearbeitet. Dies entspricht einem Expertensystem, das etwa durch eine Differentialdiagnose das zu lösende Problem immer weiter einkreist.

Bei einem neuronalen Netzwerk, ist das Wissen nicht in Regeln gespeichert, sondern durch die Verbindungsstärke (Synapsengewichte) in einem Netz von Tausenden von Neuronen, die alle gleichzeitig an der Datenverarbeitung beteiligt sind. Damit kann z.B ein Gesicht mit 10.000 Bildpunkten in einem einzigen Arbeitsschritt erkannt werden.

Einfaches Beispielnetzwerk mit zwei Schichten

Diese vereinfachte Simulation zeigt, dass durch die Wahl entsprechenden Synapsengewichte bei entsprechendem Inputmustern, die richtigen Outputneuronen angeregt werden.

Dies alles geschieht in einem einzelnen Verarbeitungsschritt. Bei einem seriellen Programm müssten in mehreren Einzelschritten alle möglichen Muster abgefragt werden. Die entsprechenden Inputmuster und möglichen Reaktionen sind also durch die Synapsengewichte fest im Netzwerk „verdrahtet.“

Das lernende Netz

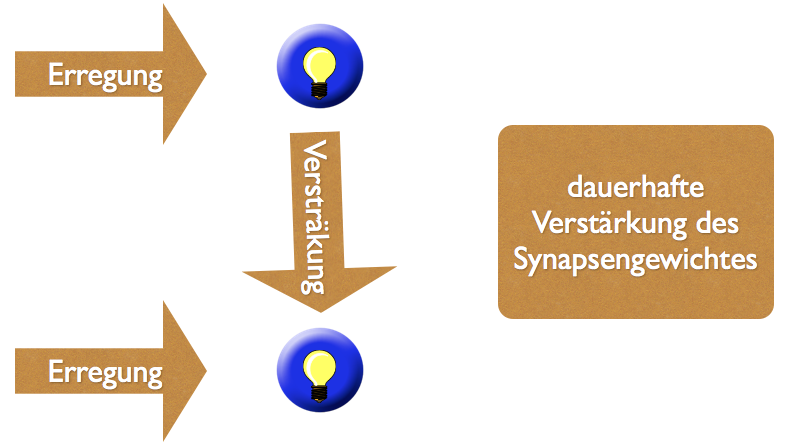

Wie aber kommen diese Synapsengewichte zustande? Bereits im vorigen Kapitel haben wir darauf hingewiesen, dass es durch die gleichzeitige Aktivierung miteinander verbundener Neuronen zu einer Veränderung des Synapsengewichts zwischen ihnen kommt. Dadurch ist es möglich, dass das Netz lernt. In Computerexperimenten kann simuliert werden, wie Netzwerke lernen. Dabei unterscheidet man zwischen angeleitetem Lernen und spontanem Lernen.

Angeleitetes Lernen

Beim angeleiteten Lernen werden dem Computernetzwerk bestimmte Inputmuster vorgegeben. Dieses reagiert darauf mit einem Outputmuster, entsprechend der zu Beginn zufällig festgelegten Synapsengewichte. Stimmt das Outputmuster nicht mit den gewünschten Suchergebnissen überein, werden die Synapsengewichte vom Systemoperator so verändert, dass sich das Outputmuster in Richtung des gewünschten Ergebnissen verschiebt. Diese Prozedur wird mit vielen verschiedenen Inputmustern solange wiederholt, bis das Netz nahezu fehlerfrei die gewünschten Outputmuster zeigt. Die Veränderung der Synapsengewichte erfolgt also von außen anhand eines externen Input-Output-Musters. Dabei spielt die Schnelligkeit der Änderung der Synapsengewichtung eine große Rolle. Werden die Synapsengewichte in nur einem Schritt verändert, legt sich das Netzwerk auf nur wenige Muster fest, bei einer langsamen Anpassung kann das Netzwerk, die in allen Mustern vorkommende Ähnlichkeit erkennen, mit anderen Worten es kann Generalisieren und auch eine ursprünglich nicht als Einzelmuster vorhandene allgemeine Form erkennen.27 Die Lerngeschwindigkeit spielt also beim Lernen von Netzen eine entscheiden Rolle.

Bereits bei diesen einfachen Simulationen lassen sich eine Menge von Schlußfolgerungen für das menschliche Lernen ziehen: In biologischen Systemen sollte die Lerngeschwindigkeit am Anfang eines Lernprozesses groß sein, um gegen mögliche Gefahren möglichst schnell schützende Reaktionen bereit zu stellen. Am Ende eines Lernprozesses sollte sie dagegen abnehmen, um das Netz immer feiner auf die Wirklichkeit abzustimmen. So lernen Kinder am Anfang schnell, während Erwachsene immer langsamer lernen, ihre Empfindungen und Wahrnehmungen dabei aber immer mehr verfeinern.

Mathematisch heißt das, dass die Vorhersagegenauigkeit langsamer wächst als die Stichprobengröße. Um die durchschnittliche Größe von Männern zu bestimmen, reicht eine Stichprobe von Männern bereits aus um eine hohe Vorhersagewahrscheinlichkeit zu erreichen. Will ich die Vorhersagegenauigkeit verdoppeln, brauche ich zusätzlich Männer. Das heißt mit wenigen Erfahrungen erreiche ich schon einen sehr großen Lerneffekt, um diesen Lerneffekt zu verfeinern brauche ich wesentlich mehr Erfahrungen. Das Spiel ist einiger der wichtigsten Instrumente, um unser neuronales Netzwerk gefahrfrei zu trainieren. Hier können die Synapsengewichte optimal eingestellt werden, bevor es zum Ernstfall kommt. Eine Kampfsituation wird erst im Spiel antrainiert, bevor es im Ernstfall zu einem Kampf auf Leben und Tod kommt.

Die Programmierung der Synapsengewichte erfolgt auch nicht durch „Predigen“, sondern durch die ständige Wiederholung von Mustern, an die sich unser neuronales Netzwerk durch Veränderung der Synapsengewichte anpasst. Wir lernen also mehr durch Beispiele als durch Predigten.

Spontanes Lernen

Beim spontanen Lernen wird die Differenz von gewünschten Input und Outputmuster nicht von außen vorgegeben, sondern das Netzwerk muss sie selbst herausfinden. In der Computersimulation ist dafür eine besondere Art von Netzwerk nötig, die diese Selbststeuerung übernimmt. Man spricht hier von Kohonennetzwerken, oder sich selbstorganisierender Karten. Wie bei dem bereits vorgestellten einfachen Beispielnetzwerk gibt es zwei Schichten. Eine Inputschicht und eine Outputschicht (auch Kohonenschicht genannt).

Jedes Neuron der Inputschicht ist mit allen Neuronen der Outputschicht verbunden, wie das schon beim einfachen Beispielnetzwerk der Fall war. Zusätzlich sind jedoch alle Neuronen der Outputschicht (Kohohnenschicht) untereinander verbunden.Wird nun bei einem untrainierten Kohohnennetzwerk mit zunächst zufällig gewählten Synapsengewichten bei einem Inputmuster ein Neuron der Outputschicht aktiviert, so wird diese Kombination fest einprogrammiert, indem die naheliegenden Neuronen der Kohohnenschicht ebenfalls aktiviert werden, entferntere Neuronen jedoch blockiert werden. Man spricht von einer „Center-Surround-Umgebung“, bei der ein Neuron als Sieger für eine bestimmtes Eingangsmuster hervorgeht. Die Selbstprogrammierung der Synapsengewichte bewirkt, dass in Zukunft nur noch dieses Neuron der Outputschicht bei dem vorliegenden Inputmuster aktiviert wird.

Das ganze funktioniert nur, wenn dem Netzwerk immer wieder gleiche Inputmuster vorgegeben werden. Bei entsprechender Zahl von Wiederholung bildet sich in der Kohonenschicht eine Karte der Eingangsmuster aus, bei der die ähnliche Muster repräsentierenden Outputneuronen nahe beieinander liegen. Dies kommt daher, weil das gewinnende Neuron immer auch die umgebenden Neuronen mitaktiviert. Die treibende Kraft für die Selbstorganisation des Netzwerkes ist dabei die Regelmäßigkeit des Inputs. Kohonennetzwerke können jede Regelmäßigkeit und jede Struktur des Inputs extrahieren und in ihrer Karte abbilden. Daraus folgt, dass für das selbstorganisierte oder spontane Lernen, die regelmäßige Wiederholung des gleichen Inputs eine wichtige Rolle spielt.

Kodierung

In den in den Kohonennetzwerken entstehenden neuronalen Karten werden Informationen kodiert.

Die Kodierung der Informationen erfolgt dabei durch Vektoren, z.B. für die Kodierung von Farben, Gerüchen etc.33 Eine Farbe setzt sich dabei, wie wir das aus der Computertechnik kennen, aus mehreren Komponenten (Blau, Rot, Gelb) zusammen.

Wahrgenommene Gegenstände werden dabei durch neuronale Muster repräsentiert. In den Begriffen der Schule des Denkens können wir auch sagen, das Gehirn simuliert die Wirklichkeit durch neuronale Muster.

Modulare Karten im Gehirn

Dabei ist nicht das ganze Gehirn ein einziges Kohonennetzwerk, sondern es gibt im Gehirn mehrere solcher sich selbstorganiserender Karten, teilweise sogar mehrere für jede Art der Wahrnehmung. Man kann sagen, dass unser Gehirn ein modular aufgebautes System von miteinander vernetzten Karten ist.

Z.B braucht der Mensch zum Sehen mehrere dieser Karten, um Bewegung, die Tiefe, die Form und die Farbe des wahrgenommen Objektes zu analysieren. Dabei läuft die Verarbeitung parallel auf zwei unterschiedlichen Pfaden: Auf dem „Was“-Pfad (Ventrale Bahn) wird analysiert, was gesehen wird, also Form und Farbe. Auf dem„Wo“- Pfad (Dorsale Bahn) wird analysiert, wohin sich das Objekt bewegt und wie weit ich von ihm entfernt bin (Bewegung und Tiefe).

Auch für das Fühlen befinden sich im Gehirn in bestimmten Hirnarealen Karten für die sensomotorische Wahrnehmung. Dabei können wir nicht mit jedem Körperteil gleich gut wahrnehmen.

Je größer die Karte im Gehirn, desto differenzierter können wir wahrnehmen. Graphisch wird dies durch Homunculus deutlich, einer Körperfigur bei dem die Größe der Körperteile entsprechend ihrer Sensibilität dargestellt ist.36 Das neurolinguistische Programmieren (NLP) geht vom Vorhandensein solcher Karten im Gehirn aus.37 Diese Karten sind ein Konstrukt des Gehirns, das die Wirklichkeit gefiltert wahrnimmt.

Begriffsbildung

Zweischichtige Netzwerke, so wie wir sie bis jetzt gebraucht haben, reichen nur bedingt aus, um die Gehirnfuktion zu simulieren. Dem widerspricht, dass unsere Inputschicht und Outputschicht, also die Neuronen der Sinneswahrnehmung und die Neuronen, die Befehle an die Muskeln weiterleiten, nur 0,1% aller Neuronen darstellen.39 Das heißt die Mehrzahl der Neuronen liegen also weder in einer Inputschicht, noch in einer Outputgschicht, sondern sie liegen in einer dritten Schicht, einer Zwischenschicht, die der internen Verarbeitung dient.

Unsere Neuronen sind also miteinander vielseitig vernetzt. In einer einfachen Simulation eines dreischichtigen Netzwerkes kann gezeigt werden, wie das funktioniert. Es geht um die Unterscheidung zwischen Rotkäppchen, dem Wolf und dem Holzfäller1 In der mittleren Schicht gibt es drei Neuronen, für jede einzelne dieser drei Erscheinungen. Werden die Entsprechenden Inputneuronen aktiviert, so wird das entsprechende Neuron der Mittelschicht aktiviert. Dies kann dann entsprechende Neuronen der Outputschicht aktivieren, die mögliche Rekationen wie „Flucht“, „Zutrauen“ usw. auslösen.

Eine entsprechende Schaltung lässt sich zwar auch mit einem zweischichtigen Netzwerk realisieren. Da jedoch jedes Inputneuron mit jedem Outputneuron verbunden werden muss, wächst die Zahl der benötigten Nervenverbindungen schnell an, was die Leistungsfähigkeiten der zweischichtigen Netzwerke stark einschränkt.

Durch die Zwischenschicht ist es dem menschlichen Gehirn möglich, zu abstrahieren.41 Logisch gesehen können dreischichtige Netzwerke auch eine exklusive Oder- Verbindungverwirklichen, diese ist bei einem zweischichtigen Netzwerk nicht möglich.42 Mehrschichtige Netzwerke ermöglichen also den Aufbau von Wissenshierarchien.

Dabei arbeiten mehrere Gehirnareale mit ihren Karten zusammen. Hirnareale, die näher an der Wahrnehmung orientiert sind, haben ein niedrigeres Niveau; Hirnareale mit höherem Abstraktionsgrad ein höheres Niveau. Pyramidenzellen verbinden dabei die Hirnareale und lassen Nervenimpulse in beide Richtungen zu. (Bottom-up und Top-Down-Prozesse). Dabei kommt es zu einer Ping-Pong-Reaktion zwischen beiden Hirnarealen.43 Dies lässt den Schluss zu, dass es im Erkennungsprozess sowohl zur Analyse als auch zur Synthese kommt. Das heißt, eine Wahrnehmung wird auf der niederen Ebene in ihre Einzelteile zerlegt (vgl. dazu oben die unterschiedlichen Karten für Farbe, Form, Bewegung usw.), gleichzeitig aber wird versucht, das Wahrgenommene zu einem bereits im Gehirn auf einem höheren Niveau vorhandenen Muster zusammenzusetzen. Dabei werden Informationen zwischen niedrigerem und höherem Areal solange ausgetauscht (Ping-Pong), bis die im niederen Areal codierte Sinneswahrnehmung mit einer im höheren Areal gespeicherten Muster übereinstimmt.(( Diese Vorgänge einer rekursiven Denkstruktur entsprechen dem von mir bereits vorgestellten doppelten Kreislauf des Denkens von Theorie und PraxisAuf einer tieferen Ebene werden die eingegangenen Daten analysiert (Praxiskreislauf). Auf einer höheren Ebene kommt es zu tieferen Wahrnehmungs- und Entscheidungsprozessen (Theoriekreislauf). Beide sind miteinander verzahnt. Die neuronale Zwischenschicht, die zwischen Input und Output liegt, verbürgt also unsere Theoriefähigkeit und damit die Fähigkeit zu höheren geistigen Operationen.))

Begriffe und damit auch unsere Module werden durch die Neuronen dieser Zwischenschicht repräsentiert. Module ermöglichen deswegen einen effektive Aufbau von neuronalen Netzwerken. Sie regulieren, bündeln und organisieren die Datenverarbeitung zwischen dem Input und dem Output. Auch das Modulsystem kennt sowohl Topdown- als auch Bottomupprozesse.

Erinnerung

In der Forschung werden noch weitere Netzwerkmodelle diskutiert, die sich durch Computer simulieren lassen. Ihre Bedeutung und Tragweite für die Funktion des Gehirns ist jedoch noch nicht ganz absehbar. Elman- und Hopfieldnetzwerke können einen Beitrag lieferen, Gedächtnisleistung und Zeitvorstellung zu verstehen.

Hopfield Netzwerk

Dazu zählt das Hopfield Netzwerk. Es besteht nur aus einer Neuronenschicht, in der aber alle Neuronen miteinander verbunden sind (ähnlich der Kohonenschicht im Kohonennetzwerk). Wird dieses Netzwerk durch ein externes Muster angeregt so bildet sich dieses Muster nach einer bestimmten Zeit innerhalb des Hopfieldnetzwerkes ab. Die Neuronen regen sich gegenseitig solange an, bis das Eingangssignal abgebildet wird. Das besondere daran ist, dass Hopfield Netzwerke mehrere unterschiedliche Inputmuster speichern können ( Menge liegt bei ca. 13% der beteiligten Neuronen). Diese gespeicherten Zustände werden auch „Attraktoren“ genannt.

Das besondere am Hopfield -Netzwerk ist, dass es sich an diese Zustände erinnern kann, auch wenn ihm nur ein Teil der ursprünglichen Information dargeboten wird. Es erinnert sich also an die gesamte Information, wenn ihm ein Teil der Information dargeboten wird (Autoassoziatives Netzwerk).

Elmann Netzwerk

Ein anderes Netzwerk ist das Elmann-Netzwerk. Dabei wird der Inhalt der Zwischenschicht in einer zusätzlichen Kontextschicht, die die Zwischenschicht eins zu eins abbildet (Synapsengewicht = 1) festgehalten. Durch den Vergleich der gespeicherten Kontextschicht mit dem aktuellem Zustand der Zwischenschicht lassen sich zeitliche Veränderungen darstellen und Signale in einem zeitlichen Kontext deuten.

Neuroplastizität

Was geschieht, wenn ein Teil eines neuronalen Netzwerkes, z.B. die durch ein Kohonen-Netzwerk kodierte Karte für akustische Signale oder für motorische Bewegungen in Folge eines Schlaganfalls, einer Gehirnoperation, einer Gliedmaßenamputation oder Ähnlichem zerstört oder gestört wird. Solange das Gehirnareal mit einem wiederholten, regelmäßigen Input beliefert wird, kann sich die Karte wieder zurückbilden.

Diese Regenerationsfähigkeit des Gehirn verdanken wir seiner Neuroplastizität oder seiner Fähigkeit, sich beständig den Erfordernissen seines Gebrauches anzupassen. Unser Gehirn ist dabei sich beständig selbst zu optimieren.

Dabei geht es nicht in erster Linie um das Heranwachsen neuer Neuronen, in dem Sinne, dass sie heranwachsen oder sich teilen, sondern um die Neuverknüpfung von Neuronen oder um das Aktivieren bisher inaktiver Verbindungen.49 Neuronen bekommen dabei eine völlig neue Aufgaben zugewiesen.

Ein markantes Beispiel dafür ist, dass Patienten nach einer Amputation zunächst diesen Arm noch als Phantom spüren. Nach einiger Zeit kann es aber sein, dass eine am Gesicht herablaufende Träne zugleich im Gesicht und zugleich im Phantomarm gespürt wird. Die einst nur für den Arm zuständigen Neuronen, übernehmen nun auch die Wahrnehmung für das Gesicht.50 Eine Simulation einer Amputation auf einem Computer durch ein Kohonen-Netzwerk macht die Vorgänge deutlich.51 Die Amputation wird dadurch simuliert, das ein Teil der Neuronen nicht mehr mit einem Inputsignal beliefert wird. Sie werden also inaktiv. Zunächst geschieht nichts. Erst wenn die Eingangssignale deformiert werden (Signalrauschen), werden durch diese zufällige Aktivierung bisher inaktiven Neuronen angeregt, sich neu zu organisieren. Das erklärt, warum amputierte Personen einen Phantomschmerz spüren könnten. Dieser Phantomschmerz ist das Rauschen, dass die inaktiven Neuronen zu einer Neuverdrahtung anregen könnte.

- nach Spitzer [↩]